Vous aimerez aussi

-

De ICI Nord à ICI Maine, cartographie des performances numériques du réseau ICI

De ICI Nord à ICI Maine, cartographie des performances numériques du réseau ICI

-

FIP Cultes prend la tête des webradios françaises dès son lancement

FIP Cultes prend la tête des webradios françaises dès son lancement

-

Triton Digital lance une nouvelle génération d’analytics pour le podcast

Triton Digital lance une nouvelle génération d’analytics pour le podcast

-

France Culture enregistre 28.5 millions d’écoutes à la demande en janvier

France Culture enregistre 28.5 millions d’écoutes à la demande en janvier

-

"Radio Ready" veut garantir l’accès à la radio dans les voitures connectées

"Radio Ready" veut garantir l’accès à la radio dans les voitures connectées

Le jury de ce hackathon était composé de plusieurs professionnels de l'équipe d'organisation du Salon de la Radio et de l'Audio Digital et de représentants des partenaires de l'événement : Digigram, RadioAct, Elson, Paris&Co/LINCC et Radio France. À cette occasion, le groupe Radio France, la bibliothèque nationale (Bnf) et mX3.ch, le portail de la musique Suisse ont tous trois ouvert leur API aux équipes afin d'aller y puiser les ressources nécessaires en termes d'applications, de sons, d'iconographies et de musiques. Avec 2 catégories de réflexion : parce que le contenu et le support de diffusion sont intimement liés et ne peuvent être pensés l'un sans l'autre, ce Hackathon a accueilli deux types de projets différents. D'une part des projets d'innovation éditoriale, pour explorer de nouveaux contenus et de nouvelles formes d'écriture ; d'autre part des projets d'innovation dans les supports d'écoute, pour explorer de nouvelles formes de diffusion.

Le prix Lincc de la radioi augmentée à "Encore" (Dig Deeper)

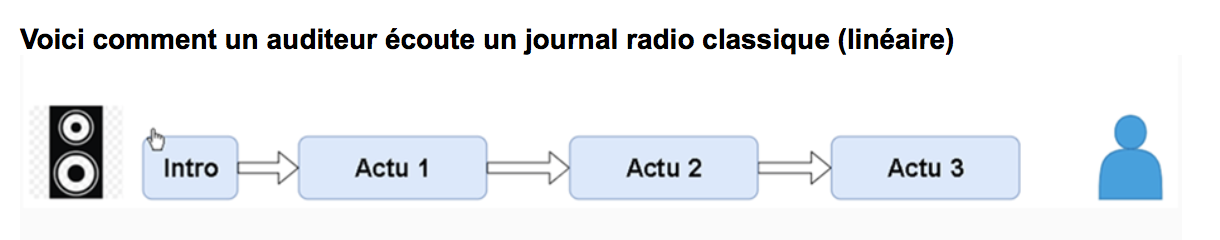

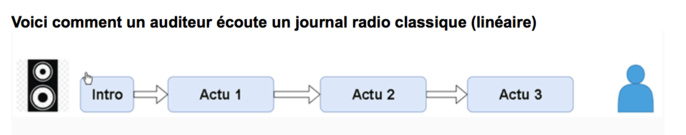

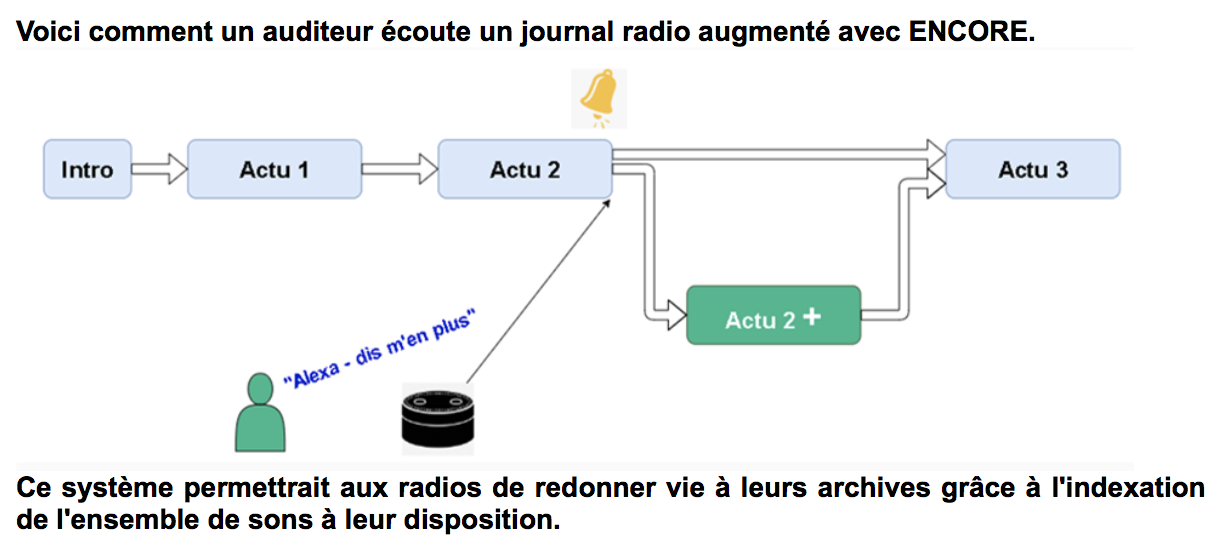

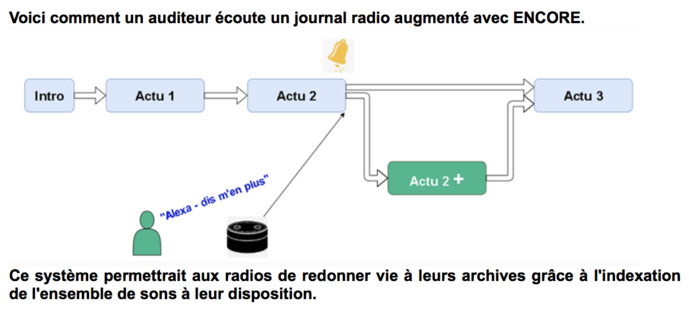

Le concept : Utiliser le potentiel des assistants vocaux (comme Alexa d'Amazon, Siri d'Apple ou Google Home) pour explorer et augmenter l'actualité d'un journal radio. Selon Fabien Randrianarisoa, reporter à Radio France et membre de l'équipe qui a présenté ce projet, une part importante des contenus d'actualité produits, montés et validés par les radio ne passent jamais à l'antenne faute de temps. "Encore" donne ainsi à l'auditeur la possibilité de demander à son assistant vocal à en "entendre plus" sur un billet d'actualité qu'il est en train d'écouter.

Avec "Encore" lorsque d'autres contenus audio sont disponibles, l'assistant vocal émet un son particulier signalant à l'auditeur qu'il y en a plus à disposition. Il suffit alors de formuler la demande par oral avec un : « Alexa, dis m'en plus ! » ou un « Ok Google, dis m'en encore ! » et l'assistant interrompt le fil d'actualité général pour lancer les contenus complémentaires sur le sujet et permettre à l'auditeur de creuser une actualité particulière.

Le prix Digigram de l'intéractivité augmentée à "Composer"

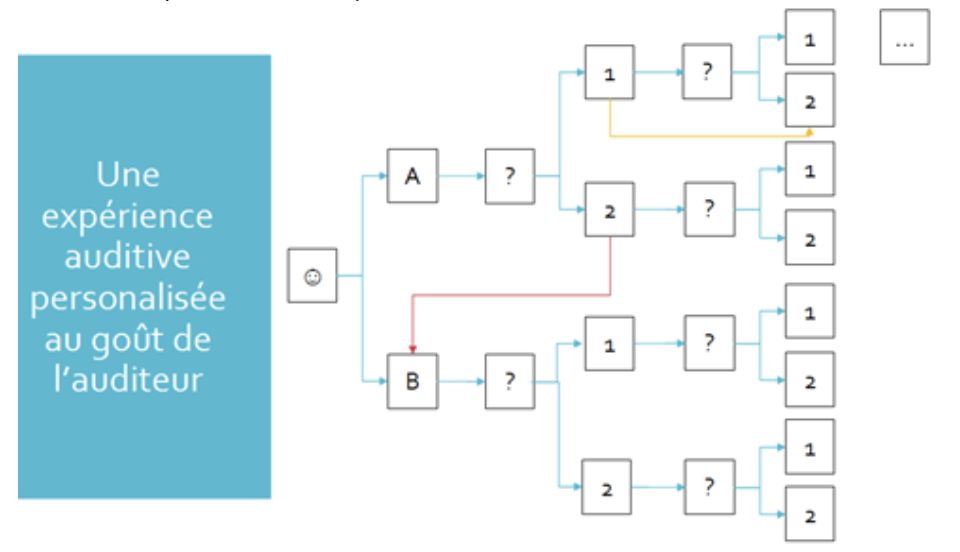

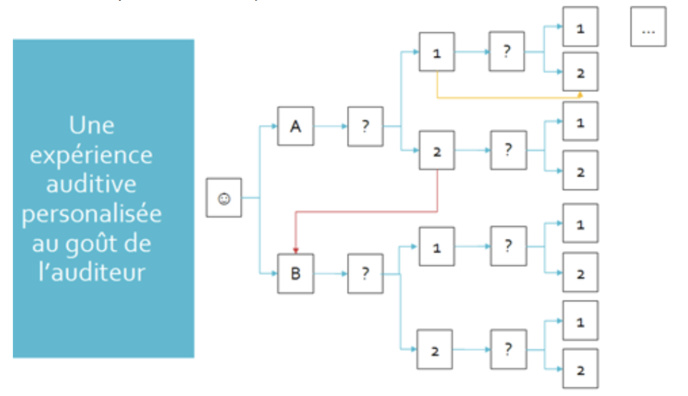

Avec "Composer", l'utilisateur a le choix sur le scénario du podcast qu'il écoute. Cela permet de "se déplacer" dans un podcast, afin qu'il soit "acteur de sa propre écoute" avec une expérience immersive ; ou encore de "sauter" les passages d'un épisode qui pourraient ne pas l'intéresser (interviews, etc.). L'équipe à l'origine de ce projet voulait proposer aux personnes utilisant Composer une interactivité augmentée avec un vrai pouvoir sur le fil narratif, dans la même veine que les "livres dont vous êtes le héros" pour les plus anciens qui ont connus l'engouement pour ce format dans les années 80/90 ou plus récemment l'épisode interactif Bandersnatch de la série Black Mirror.

Le prix RadioAct de la narration augmentée à "MIA"

L'équipe qui a présenté Le procès de MIA souhaitait proposer un docu-fiction audio interactif pour smartphone et assistants vocaux. La démonstration lors du pitch final a été réalisée avec une enceinte Google Home. L'idée : en 2041 les Intelligences Artificielles sont partout et c'est l'I.A. de votre assistant vocal qui est à la fois le narrateur et le personnage principal de ce Docu-fiction : MIA à qui les humains ont décidé d'intenter un procès. MIA prend ainsi la parole et interpelle directement les auditeurs dans une discussion engagée entre humains et I.A.

Avec Le procès de MIA, au lieu de proposer ce contenu sous forme classique (comme on pourrait le retrouver dans un épisode du podcast de fiction) l'I.A. s'exprime directement via une enceinte Google Home. Elle pose des questions à l'auditeur qui doit fournir des réponses et exprimer des choix qui vont influer sur la narration. En parallèle, MIA va chercher et diffuser des sons, des actualités, des archives, des interviews de philosophes, de scientifiques, etc. en rapport avec le sujet. Cette nouvelle forme de narration augmentée permet de manière réaliste, interactive, immersive et personnalisée d'interroger notre responsabilité et de développer notre réflexion de manière enrichie.

Deux autres projets présentés lors de ce Hackathon

D'abord OSATT ("Operating System for Audio Time Travel"). L'idée est ici de proposer à l'auditeur, grâce une appli mobile, de découvrir l'histoire d'un lieu à travers une ballade sonore augmentée (avec de simples écouteurs et un smartphone). Tout au long de son parcours physique à travers un site particulier (historique, culturel,...), l'auditeur va passer par des portails temporels (marqués au sol ou grâce à une signalétique particulière et reconnu grâce à un système de puces RFID) et déclencher des capsules sonores sur son système d'écoute, des archives sonores d'il y a 20 ans, 30 ans, 60 ans, des reportages historiques qui vont plonger l'auditeur en immersion totale dans l'histoire avec un grand H ou les plus petites histoires liés à l'endroit où il se trouve précisément. La démo devant le jury a été présentée avec l'exemple d'une balade autour de la Grande Halle de La Villette (lieu où se déroulait le Salon de la Radio), avec un son présentant l'ambiance de ce lieu dans les années 40, qui était à l'époque un abattoir.

Ensuite, "IZICAST" qui se positionne comme une application mobile permettant de découvrir des nouveaux podcasts, de partager avec ses amis des épisodes (en précisant des curseurs de lecture précis) et de devenir un prescripteur de référence. En lançant l'application, l'utilisateur sélectionne ses intérêts, puis la durée d'écoute souhaitée. Un algorithme se charge de fournir une playlist de podcasts sur mesure. L'utilisateur peut alors supprimer des épisodes (qui seront aussitôt substitués par d'autres contenus) et éditer l'ordre de lecture des audios.